Dénes Tamás matematikus-kriptográfus

e-mail: titoktan@freemail.hu

A Turing-teszt az e-társadalom napi gyakorlata

A.M.Turing

születésének 90. évfordulójára ajánlva

Virtuális agárverseny effektus:

Érjük utol a nem létező nyulat egy virtuális

agárversenyen!

1. Gondolatok

a Turing-teszt előtt

Most nem engedjük elkalandozni

gondolatainkat több ezer éves távlatokba, a "már az ókori görögök is ismerték"

szokásos fordulatot használva, mégis lenyűgöző az a gondolkodásfejlődési ív, amely

elvezetett a mechanikus számoló-gépektől a mai infokommunikációs rendszerek technikai

alapját képező digitális gépekig. Talán nem tanulság nélküli ez a történeti kitérő

Neumann János születésének centenáriumi évében, amelyből kiderül, hogy milyen

óriások vállán állt, amikor a XX.század második felének és a jelen fejlett társadalmainak

gyökeresen új irányt szabott, a számítástechnika megalapozásával.

Bár valóban az emberiség

a kezdetektől alkalmazott a számolás megkönnyítésére különböző eszközöket (ilyenek

voltak a legrégebbi ismert eszközök, a rováspálcák, majd az abakusz), jelen témánk szempontjából azonban

csupán vázlatosan teszünk említést azokról az eszközökről, amelyek már a mai értelemben

is számoló-gépeknek nevezhetők. Ehhez elegendő a XVII. századig visszapergetni

a naptárt, amikor 1642-ben Blaise Pascal

(1623-1662) megszerkesztette fogaskerekes összeadógépét, az arithmométert.

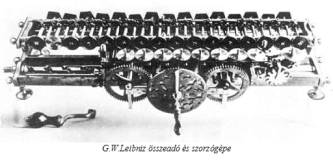

Ennek tökéletesített formája volt 1671-1673-ban

Gottfried Wilhelm Leibniz (1646-1716) összeadó és szorzógépe, amellyel mind a

négy alapműveletet el lehetett végezni, sőt Leibniz már ekkor javasolta a számológépeknél

a 2-es számrendszer használatát[1]!.

Ezekkel a fogaskerekes eszközökkel

egyre több és egyre nagyobb számokon végzett műveleteket lehetett a fejben, vagy

papíron történő számoláshoz képest igen gyorsan elvégezni, ezért a XVIII. században,

főleg Franciaországban már sorozatban gyártottak ilyen készülékeket.

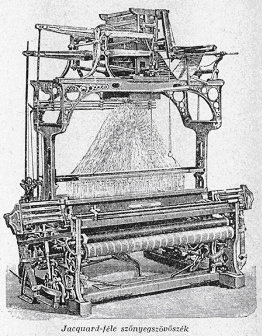

Igen nagy előrelépést jelentett

a változtatható fogazású, majd a lyukkártyás vezérlésű gépek bevezetése. Az első

ilyen gépek Joseph Marie Jacquard (1752-1834)

nevéhez fűződnek, aki 1810-ben elkészítette

első lyukkártya vezérlésű szövőgépét,

amely már lehetővé tette a selyemszövetek különböző mintázatokkal történő automatikus

gyártását.

Jacquard halálakor több tízezer

ilyen szövőgép üzemelt. A lyukkártyás vezérlés ötlete és technikája a szórakoztató

iparban is megjelent például a XVIII.-XIX. századi zenegépekben. Száz évvel később,

az 1960-as, 1970-es évek számítógépeinek kulcsjelentőségű perifériája lett a lyukkártya

olvasó, amely már az adatokon túl a programok beolvasására is szolgált!

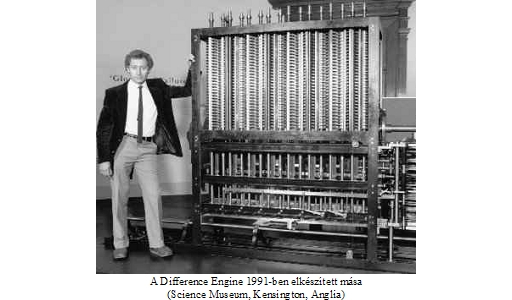

A számítástechnika és így

a "gondolkodó gépek" felé vezető út szempontjából igazi áttörést Charles Babbage (1792-1871) angol matematikus

tevékenysége jelentett, akinek először jutott eszébe, hogy a lyukkártya alkalmas

lehet az elemeire bontott számítási eljárások gépbe táplálására is. A mintegy

tíz évi munkával készített első gépe, a Difference Engine[2]

képes volt nagy számtáblázatok automatikus elkészítésére, ami méltán váltotta

ki a korabeli csillagászok elismerését, melynek kifejezésére a csillagászok egyesülete

aranyéremmel tüntette ki. Babbage azonban gépét továbbfejlesztette és grandiózus

tervekkel foglalkozott, melynek eredménye, új számítógépe, az Analytical Engine sohasem készült el, mivel

az 1000 tengely és az 50 helyiértékes számokhoz

tartozó fogaskerékrendszer technikai kivitelezése olyan technikai precizitást

igényelt, amelyre az akkori ipar képtelen volt.[3]

Babbage gépe méltánytalanul feledésbe

merült, pedig az az automatizált számítógépek

ősének tekithető. Babbage ugyanis felismerte

azt, hogy szükséges a számítási folyamat közben keletkező részeredmények tárolása

is. Ugyanakkor az Analytical Engine valósította volna meg először azt az elvet,

hogy a gép előre meghatározott (és lyukkártyák segítségével változtatható!) algoritmus

szerint végezze a számításokat, vagyis mai fogalmaink szerint, ez lett volna

az első programozható "számítógép". Babbage gépe tehát szerkezeti

elemeit (architektúráját) tekintve (aritmetikai egység, operatív tár, vezérlő

egység), pontosan megfelelt a napjainkban is használt, úgynevezett Neumann elvű

számítógépeknek. Mindez szinte pontosan 100 évvel Neumann János előtt!

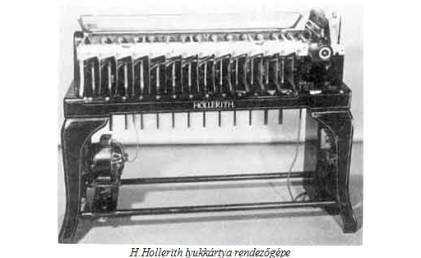

A Babbage-nél még mechanikus elemekből felépülő

lyukkártyás rendszert csupán az elektronika felhasználásával modernizálta a XIX.

század végén, az Amerikai Statisztikai Hivatal igazgatója

Herman Hollerith (1860-1929), aki 1889-ben

a népszámlálás adatainak feldolgozására egy rendezőgépet dolgozott ki. Minden

állampolgárhoz egy adatsort (számsort) rendelt, amely számokat egy 80 oszlopból és 10 sorból álló kártyán lyukasztással rögzítettek. A rendezőgép olyan

elektromágneses szerkezet volt, amely a kártyák oszlopainak megfelelő távolságokban

pontosan 80 letapogató fémtűvel rendelkezett,

így amikor a görgősoron egy kártya a tűk alá került, akkor azok a tűk, amelyek

a kártyán lyukat "találtak", zárták az elektromágnes áramkörét, amely

azon a padon, amelyen a kártya elhaladt, kinyitotta a lyukasztásnak megfelelő

ajtót, amelyen át a kártya a neki megfelelő dobozba esett[4].

Az elektromosság alkalmazása

felgyorsította a számológépek fejlődését és a XX. század elején mind tökéletesebb

elektromechanikus gépeket készítettek. Az Amerikai Egyesült Államokban Howard Hathavay Aiken elkészítette a MARK-I és MARK-II elektromechanikus

analitikus számítógépeket, amelyekben egy összeadáshoz 0,3-0,5 sec, egy szorzáshoz 5-6 sec, míg egy osztáshoz 15 secundum kellett. Mindehhez (mint az a 6.

képen látható) egy hatalmas teremre volt szükség.

Norbert Wiener (1894-1964)

1940-ben megfogalmazta a korszerű számítógépek

"5-parancsolatát":

1.

A

számítógép aritmetikai egysége numerikus legyen.

2.

A

mechanikus és elektromos kapcsolókat fel kell váltani elektroncsövekkel.

3.

Az

aritmetikai műveletek elvégzésére a 2-es számrendszert kell alkalmazni.

4.

A

műveletsort a gép emberi beavatkozás nélkül, automatikusan végezze úgy, hogy a

közbenső logikai döntéseket is be kell táplálni. (Mai

szóhasználattal, ez a program.)

5.

Legyen

lehetőség az adatok tárolására, könnyű előhívására és törlésére.

A II. világháború alatt rohamosan fejlődő hadiipar

sorra vetette fel a rengeteg számolást igénylő feladatokat (például a nagy hatótávolságú

lövedékek lőelemtáblázatai, lövedékek gyors röppályaszámítása, az atombomba kísérletek

számításairól nem is beszélve), amelyek sürgették a "számítógépek 5-parancsolatának"

gyakorlati megvalósítását.

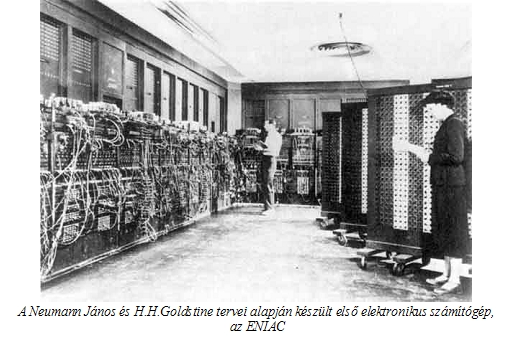

Így készült el Neumann János és Herman H.Goldstine tervei alapján

1943-1946 között az első elektronikus számítógép, az ENIAC

(Electronic Numerical Integrator And Calculator), a philadelphiai Pennsylvania Egyetemen. Az ENIAC egy

elektronikus kolosszus volt, amely 30 tonnát nyomott, egy több mint 30 méter hosszú

terem kellett az elhelyezéséhez és a 18000 elektroncső 100-150 kWó energiát fogyasztott

(ezért a hűtése igen nagy problémát jelentett).

Az ENIAC még nem felelt meg

egészen a "számítógépek 5-parancsolatának", hiszen aritmetikája

10-es számrendszerben működött. Számítási teljesítménye azonban a MARK-I

és MARK-II gépekéhez viszonyítva lenyűgöző volt, az összeadást és kivonást 10 tizedes pontossággal 0.0002,

a szorzást 0.0023 secundum alatt végezte

el. Memóriájában mindössze húsz darab tízjegyű számot lehetett tárolni, így program

tárolására nem volt alkalmas, a programozását egy huzalos dugaszolótábla tette

lehetővé.

Ezen adatok ismeretében még

nagyobb tisztelettel kell adóznunk C. Babbage száz évvel korábbi teljesítménye

előtt és egyáltalán nem csodálkozhatunk azon, hogy annak megvalósítása akkoriban

kudarcba fulladt.

Neumann János és H.H.Goldstine

az 1940-es évek elejétől foglalkoztak a számítógépek elméleti és gyakorlati problémáival.

Kutatásaik eredményét egy bizalmas jelentésben foglalták össze 1948-ban, amely

először tartalmazta az univerzális, belső programvezérlésű, elektronikus, digitális

számítógép tervét. Ebben egyértelmű érvekkel alátámasztva állást foglaltak a már

Leibniz által ajánlott bináris számrendszer mellett, valamint megoldották a programtárolás

módját is. Így lehetővé vált az adatok és részeredmények tárolásán kívül, a végrehajtandó

utasítások tárolása is a számítógép memóriájának egy erre fenntartott részében.

Az ENIAC tapasztalatait felhasználva,

már ezen elveket valósította meg, az 1948-1949-re elkészült EDVAC (Electronic Variable Automatic Computer),

amelyet tervezője Neumann János tiszteletére "Johnnyac"-nak is hívtak[5].

Érdemes felfigyelni ez utóbbi

elnevezések közötti (látszólag jelentéktelen) eltérésre, amely már tükrözi azt

a jelentős különbséget, amely a mind nagyobb teljesítményű, a szó szoros értelmében

vett számoló gépek (minél nagyobb számokkal,

minél gyorsabban végzett műveletek) és a változtatható és tárolt programokkal

programozható számítógépek között van.

Ez az a pont, ahol kezd versenytárssá

válni a gép és az ember, ahol már a nagy mennyiségi teljesítményekre képes automatikusan működő,

de alapjában véve egyszerű gépek helyére lépnek a programvezérelt automaták. Az

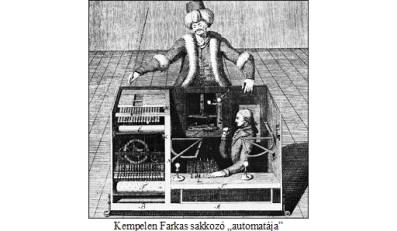

automaták már az 1800-as években Kempelen Farkas zseniálisan szélhámos "sakkozó

automatája"[6]

idején is nagy csodálattal töltötték el az embereket.

Később a logikai gépek, majd

az emberi funkciókat modellező automaták, már elkerülhetetlenné tették a programnak,

mint matematikai fogalomnak a definiálását.

Éppen Alan Mathison Turing[7] (1912-1954)

volt az, aki az 1930-as években

elsőként adta meg a program és a programozható számítógép matematikai modelljét,

a róla elnevezett Turing-gép definícióját. Ez a gép tulajdonképpen

egy absztrakt automata, amelyre teljesül az a meghökkentő tétel, melyet Alonzo

Church amerikai matematikus 1936-ban állított fel és amely szerint minden programhoz

található egy azzal ekvivalens Turing-gép és fordítva, minden Turing-gép egy programot

(algoritmust) valósít meg, azaz a Turing-gép tökéletes modellje a program fogalomnak. A Turing-gép, mint minden

igazán zseniális elképzelés, könnyen leírható:

Képzeljünk el egy olyan automatát, amely véges sok szimbólumot (jelet) képes

feldolgozni úgy, hogy egy adott időpillanatban egyetlen szimbólumot képes leolvasni,

vagy felírni egy elvileg végtelen szalagra. A feldolgozást egy speciális jel,

a STOP jel feldolgozásakor fejezi be.

Ebben az absztrakt definícióban

valóban benne van a jelek hosszabb jelsorozatokká való összeláncolásának és így

tetszőleges bonyolultságú utasítások létrehozásának és tárolásának, a végrehajtás

közben keletkezett jelek (adatok) tárolásának lehetősége, vagyis mindazon funkciók

elméleti lehetősége, amelyeket egy évtizeddel később, Norbert Wiener

a korszerű számítógépek "5-parancsolata"-ban foglalt össze.

A programok, az automaták,

a számítógépek számtalan elméleti kérdést vetettek fel, amelyek megválaszolására

részben a matematikai logika, az absztrakt algebra és más matematikai területek

segítségével kerestek válaszokat, részben egészen új tudományterületek születtek,

mint például az automata elmélet, a kibernetika, a számítógép tudomány, vagy az

információ elmélet.

2. A Turing-teszt

A programozható gépekkel

kapcsolatban, szintén a XX. század 30-as

éveiben vetődött fel a kérdés, hogy létezik-e (létezhet-e) olyan programozási

feladat, amely nem oldható meg? Azaz a Church-tézis szerint, létezik-e olyan programozási feladat, amelyhez

nem található Turing-gép ?

Nos, 1937-ben A.M. Turing

bebizonyította, hogy a válasz "igen", mivel azok és csak azok az algoritmusok

programozhatók, melyekhez úgynevezett rekurzív függvények tartoznak.

A matematikának azt a területét, amely eme kérdések egzakt tárgyalását

tűzte ki céljául, kiszámíthatóság elméletnek, algoritmus elméletnek, illetve Turing

előbbi tétele szerint a rekurzív függvények elméletének nevezzük. Ezek az elméleti

területek leegyszerüsítve a következő kérdéssel foglalkoznak:

Melyek azok a számítások, amiket a számítógép el tud végezni, ha minden

gyakorlati jellegű korláttól eltekintünk (mint például a rendelkezésre álló idő

és tárkapacitás) ?

A.M. Turing tehát kereste saját konstrukciójának a korlátait

és egyben a mesterséges intelligencia kutatások előfutárának is tekinthető, mivel

Ő vetette fel elsőként azt a kérdést, hogy mit is jelent a "gépi intelligencia"

?

Az első megválaszolásra váró

kérdés persze az, hogy létezik-e ilyen, hiszen a máig létező többségi felfogás

szerint intelligenciával csupán az ember rendelkezik, ezért a "gépi intelligencia"

szóösszetétel értelmetlen. Turing azt is jól látta, hogy az intelligencia és gondolkodás

fogalmak egymástól elválaszthatatlanok, ezért fogalmazta meg

1950-ben megjelent, klasszikussá vált cikkében, a dolgozatom elején idézett,

egyetlen mondatba sűrített kérdését: "…

tudnak-e a gépek gondolkodni ?"

Ezzel a kérdéssel és az ezt

követő gondolataival indította útjára, a napjainkban egyre aktuálisabb mesterséges

intelligencia kutatást. Turing szerint a "gondolkodni" szó inkább érzelmi

kérdéssé teszi ezt az egész kérdéskört, ezért el is vetette, mint túlságosan bizonytalan

(szubjektív) fogalmat. Ugyanakkor az 1950-es években sokan úgy gondolták, hogy

Kurt Gödel (1906-1978) nemteljességi tétele a mesterséges intelligencia

lehetetlenségét is bizonyítja:

A mesterséges intelligencia mindig "egy program", azaz egy Turing-gép

(Church-tézis). Az ebben a gépben tárolt axiómarendszer meghatároz egy "nyelvet",

amely nyelven megfogalmazható olyan kérdés, amelyre ebben az axiómarendszerben

nem vezethető le igen-nem jellegű válasz (Gödel-tétel). Tehát e mesterséges intelligencia

számára érthető nyelven, megfogalmazható olyan kérdés, amelyre nem tud sem igennel,

sem nemmel válaszolni !

Bár ez az érvelés több sebből

vérzik, témánk szempontjából csupán egyet emelek ki ezek közül: Ha a mesterséges

intelligenciát, mint az emberi intelligenciát utánzó konstrukciót fogjuk fel,

akkor ennek megvalósíthatatlanságát nem bizonyítja az az érv, hogy bizonyos kérdésekre

nem tud felelni, hiszen ez az emberi gondolkodásnak is jellemzője.

A rekurzív függvények elméletének,

a matematikai nyelvészetnek jelentős alakja, a magyarországi kibernetikai iskola

megalapítója, Kalmár László (1905 – 1976) az 1948-as amszterdami Filozófiai kongresszuson

tartott előadásában bebizonyította, hogy a Church-tétel a Gödel-tételből levezethető,

így Church tétele nem bizonyíthatja abszolút eldönthetetlen probléma létezését.

Kalmár László hangsúlyozta,

hogy ezeket a tételeket (Gödel, Church) szabatosan úgy kellene megfogalmazni,

hogy a kérdéses problémasereg általános rekurzív eljárással nem oldható meg, nem

pedig abszolút megoldhatatlanságról beszélni (lásd [KALM 86]).

Turingot az ellenvetések

és főleg a "gépi intelligencia" fogalmának bizonytalansága csak inspirálta

egy új megközelítés felvetésére. Ennek lényege, hogy e szubjektív és ezáltal tudományosan

megfoghatatlan fogalmak helyett, egy olyan módszert kell konstruálni, amelyet

jól definiált technikai fogalmakkal lehet leírni. Javaslata szerint ez az általa

"utánzási játéknak" nevezett módszer, melyet manapság Turing-teszt,

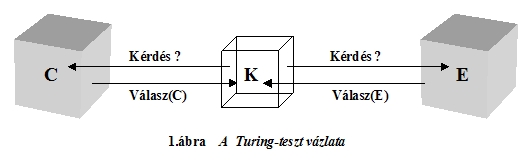

vagy Turing-próba néven ismerünk. A Turing-teszt lényege (lásd 1.ábra):

Képzeljük el, hogy egy C számítógép és egy E ember két külön helyiségben

van elkülönítve és mindketten elektronikus kapcsolatban vannak egy harmadik

helyiségben levő K személlyel, aki elektronikus

úton kérdéseket tehet fel mindkettejüknek. K-nak az a célja, hogy a kérdéseire

érkező válaszokból meg tudja különböztetni, hogy mely válasz származik C-től és melyik E-től.

A teszt egyik óriási előnye,

hogy az intelligenciáról, gondolkodásról való elmeélesítő gondolatkísérletek síkjáról,

gyakorlatban kivitelezhető és a probléma lényegét megragadó eszközt kaptunk a

kezünkbe. Hiszen most már az eredeti kérdés

helyett azzal a jól kezelhető kérdéssel állunk szemben, hogy "van-e

olyan gép, amely ezt a játékot jól tudja játszani?"

Az eredeti Turing probléma

valóban a gépi és emberi intelligencia megkülönböztetése volt. A mesterséges intelligencia

kutatások célkitűzése tehát, a gépek alkalmassá tétele arra, hogy az embert minél

pontosabban tudják utánozni.

Turing eme korszakos cikkében kifejezte meggyőződését,

hogy a XX. század végére a gépek már elég jól fogják játszani ezt a játékot ahhoz,

hogy egy átlagos kérdezőnek nem lesz 70%-nál több esélye az azonosításra 5 percnyi kérdezés után.

3. A Turing-teszt és az e-kommunikáció

Vajon ha A.M.Turing megérte

volna éppen 2002-ben esedékes

90. életévét, hogyan értékelné saját ötven évvel ezelőtti elképzeléseit

?

Valószínűleg elismerné, hogy

fantáziája nem volt elegendő ahhoz, hogy előre lássa azt a technikai robbanást,

amely a számítástechnikában, elektronikában, kommunikáció-technológiában bekövetkezett,

s amelynek eredményeként a jelenünk, mindennapjaink részévé, napi gyakorlattá

vált a Turing-teszt.

A mai információsnak

nevezett, információ alapú, vagy inkább e-kommunikációs társadalom ugyanis egy

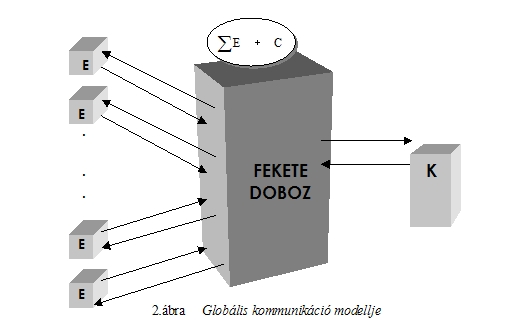

"FEKETE DOBOZ" modellt valósít meg. Ebben a modellben (lásd 2.ábra)

egy óriási információ tárolóval (ez a "fekete doboz") kommunikál minden

felhasználó úgy, hogy a felhasználók EGYMÁS SZÁMÁRA valójában ISMERETLENEK és

csak a "fekete doboz"-hoz való csatlakozás követel meg egyszerűbb, vagy

szigorúbb azonosítást ("bemutatkozást"), fordítva ez ellenőrizhetetlen.

Ma az internet egyik fő vonzereje a "globális névtelenség", ami egyúttal

számos visszaélés és bűncselekmény forrása is.

A modell tehát úgy működik,

hogy mindenki egy közös dobozba ("fekete doboz") helyezi be az információit

(lehet az személy, cég, intézmény, stb.)[8]

és ebből mindenki annyit vehet ki, amennyire a „fekete doboz” engedélyt ad.

A 2.ábra globális kommunikációs modellje, melyet

e folyóiratban már más kontextusban is ismertettem (lásd [DÉNT 02/3]) tulajdonképpen

egy megsokszorozott Turing-modell, ahol mindenki a géppel kommunikál elektronikusan,

így mindenki lehet kérdező (K) és kérdezett (E), a gép pedig összegyűjti és tárolja

a ![]() információt. A globális

modell tehát tömören leírható Arkagyij Rajkin szavaival:

információt. A globális

modell tehát tömören leírható Arkagyij Rajkin szavaival:

"Én vagyok itt (K). De ki van odaát ?!"

A válasz, mint látni fogjuk

az információs társadalom kulcskérdéséhez vezet. A.M.Turing idézett 1950-es cikkében tesztjét így fogalmazta meg:

"Azt állíthatjuk, hogy egy gép gondolkodik, ha kérdéseket tehetünk

fel neki, éspedig tetszőleges kérdéseket

és az úgy válaszol, hogy ha nem 'nézünk oda', nem tudjuk, hogy a felelet géptől, vagy embertől

származik-e."

Turing gondolatmenete látnoki

volt, ugyanis tökéletesen illeszkedik a jelen e-társadalmának 2.ábrán felvázolt globális kommunikációs hálózataira.

A kommunikációs hálózat minden felhasználója (E1,E2,…,K)

valóban egy monitor előtt ül és kérdéseket tesz fel. A monitoron megjelenő válaszok

tartalmából azonban, ha odanézünk sem dönthető el biztosan a válaszoló „személye”,

így annak valódi, vagy virtuális volta sem! (Természetesen itt a „személy” jelölhet csoportot,

céget, szervezetet, stb.) A válaszoló személyének

bizonytalansága tehát felveti az ÁLTALA KÉPVISELT INFORMÁCIÓK VALÓDISÁGÁNAK, A

VIRTUÁLIS INFORMÁCIÓKNAK a problematikáját. Így válik ez az elektronikus kommunikációs

rendszerek és ezáltal az információ alapú társadalom kulcskérdésévé.

Azt már Turing is látta, sőt elméletileg bizonyította,

hogy ha egy gép tökéletesen játsza az "utánzási játékot", akkor a

Turing-teszt kérdésfeltevése ("Mesterséges

vagy természetes intelligenciával állunk szemben?") eldönthetetlen. A

globális kommunikációs modellben ugyanakkor a

C gép igazából nem a saját,

hanem a sok-sok E1 ,E2

,E3 ,… felhasználó intelligenciájával "játszik", így

K-val szemben emberi intelligenciák sokasága áll. E modell kísértetiesen

hasonlít Kempelen báró 200 évvel ezelőtti

"sakkozó automatájához", amelynek saját korában csodájára jártak, az

utókor pedig egy szélhámos szemfényvesztéseként tartja számon. Pedig Kempelen

"automatájában" csupán egyetlen pici, ámde zseniális emberke kuporgott

!

A globális e-kommunikációs

rendszerekben elhelyezett gépek, mint információgyűjtő fekete dobozok, túl jól

játszák az "utánzó játékot", így sajnos a mesterséges és természetes

intelligencia megkülönböztetésének problematikája hosszú időre a titkos kutatólaboratóriumokba

szorult, míg eme e-kommunikációs rendszerekben a "Valódi vagy virtuális információ?"

alapkérdés váltja fel. Ez egy egészen új kihívás.

Míg Turing elképzelése szerint a K kérdezőhöz

a két féltől jövő válaszok (E,C) összehasonlítása fogódzót adhat a "gép

vagy ember?" kérdés eldöntésére, addig az e-kommunikációban ilyen fogódzó

nincs, hiszen minden válaszoló, gép által leképezett ember. Az e-modellben

tehát (Kempelen sakk-automatájával ellentétben) világos, hogy az "automatában

ember ül", de a kilétét és állításainak valódiságát éppen a "tökéletes

utánzás" fedi el.

Egy olyan társadalomban,

amely az információk szabadon áramló, tömeges áradatára épül (információ alapú

társadalom), reménytelen vállalkozás minden információ valódiságát egzakt módon

ellenőrizni, így egyre nagyobb jelentőséggel

bír az információforrások "beolvadása" a "fekete dobozba",

amellyel az információ így szinte teljesen személytelenné válik.

A K

kérdező számára tehát már nem az a kérdés, hogy emberi, vagy gépi intelligenciával

áll szemben, hanem azt kell eldöntenie, hogy a kérdéseire érkező válaszok valódi,

vagy virtuális "személytől" származnak, azaz döntéseket építhet-e rájuk,

vagy sem. A K

kérdező így teljesen kiszolgáltatott helyzetbe került, ami döntései szempontjából

is jelentős bizonytalanságot jelent.

Az információ mennyiségének,

bizonytalanságának mérésére vezetett be Claude Shannon (1916-2001) matematikai

egzaktsággal kezelhető fogalmat, az információ entrópiát [SHANN 48]. Ennek felhasználásával

mutatta be a jelen cikk írója [DÉNT 01/1]-ban, hogy a globális hálózatok (ilyen

az információ alapú társadalom is!) biztonsága jóval kisebb, mint a "rendezettebb

struktúrájú", azaz hierarchikusabb struktúrájú hálózatoké.

Az információs társadalom

kulcsfogalma tehát az információ biztonság, azaz a titkos[9]

és nyilvános információk jó elkülönítése, tárolása, továbbítása, hiszen az e-kommunikáció

dominanciája egyre jobban kizárja a hagyományos értelemben vett személyes azonosítást,

a tapasztalatokon nyugvó ellenőrzést, így a legkülönbözőbb mesterséges azonosító

eszközöket kell alkalmaznunk. A mesterséges azonosításhoz egyre több titkos kód,

jelszó, kulcs megőrzésére, tárolására kényszerülünk, hiszen ezek mindegyike számunkra,

vagy más közös érdekeltségű csoportok számára, értékes információkat takar (hitel

kártyák, telefon kártyák, igazolvány kártyák, PIN kódok és jelszavas azonosítók,

stb.), akárcsak a fekete doboz "labirintusának titkos ajtója". A titkolódzás az e-kommunikációban általánossá

válik, kilép a titkosszolgálatok szűk világából és mindennapjaink része lesz.

Egyre nyilvánvalóbb a "nyíltan titkolódzás" szükségessége, amely "paradox

játék" nagyon hasonlít a Turing-tesztre, sőt mára önálló területté vált

a kriptográfiában (rejtjelzéstanban), ez a "zero-knowledge proof",

azaz az "előismeretek nélküli bizonyítás".

4. A "zero-knowledge

proof"

A probléma megfogalmazása

igen egyszerű, ha észrevesszük, hogy a globális

kommunikáció 2.ábra szerinti modelljében a szerepek felcserélhetők, azaz mindenki

lehet kérdező és kérdezett, valamint fenti gondolatmenetünk szerint a gép és a

számtalan felhasználó sem különböztethető meg információelméleti alapon.

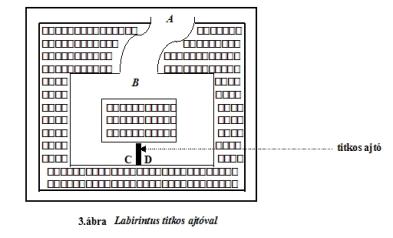

Tételezzük fel, hogy a "fekete dobozban" egy labirintus van, mely

egy titkos ajtót rejt, amelyen mindenképpen át kell jutni ahhoz, hogy a labirintus

egyik feléből a másikba jussunk (lásd 3.ábra). A B játékos ismeri az ajtó titkát (ki tudja nyitni azt!), de úgy kell ezt

bebizonyítania az A játékosnak,

hogy közben magát a titkot ne árulja el. Ezt nevezi a nemzetközi szakirodalom

"zero-knowledge proof"-nak, azokat az eljárásokat, amelyek alkalmasak

az ilyenfajta bizonyításra, "zero-knowledge protocol"-nak (lásd [PETSO 88],[STEW 96],[WAYN 87]).

Íme egy általános eljárás

(protocol) az előismeret nélküli bizonyításra:

1.

Az A játékos

a labirintus bejáratánál áll, míg a B játékos eltűnik a labirintusban.

2.

Az A játékos

két dolgot kérhet B-től:

-

Gyere

ki a jobboldali folyosón!

-

Gyere

ki a baloldali folyosón !

3.

Mivel

a B játékos a titkos ajtó egyik oldalán

állhat csak (C vagy D), így ahhoz, hogy

a kérést mindenképpen teljesítse, feltétlenül ki kell tudnia nyitni a titkos ajtót.

4.

Az A játékos

n-szer ismételheti meg a kérést és a B játékos mind az n-szer teljesíti.

Így a B játékos bebizonyítja, hogy ismeri a titkot,

de A-nak

mégsem kell elárulnia azt. Ha csak egyszer játszák el a 2.-3.lépéseket (n=1), akkor az A játékos bizalmatlanul mondhatná, hogy 1/2 valószínűséggel,

véletlenül is átjuthatott a titkos ajtón a B játékos. Ha azonban 10-szer, vagy akár 20-szor

ismétlik meg a 2.-3.lépéseket, akkor már

mindössze ![]() a tévedés valószínűsége.

a tévedés valószínűsége.

A zero-knowledge protocolok

jelentősége egyre nyilvánvalóbb, így a szakirodalomban és a gyakorlati információ

védelemben is egyre nagyobb szerepet töltenek be. A modell analógia alapján könnyen belátható,

hogy ilyen „labirintus” szituációban vagyunk minden bankautomatánál, kártyával

történő fizetésnél, vagy akár telefonálásnál, vagy például az email boxunkba való

belépésnél.

Jelen cikk célja a figyelem

ráirányítása arra az alapvető paradigma váltásra, amely a globális e-kommunikációval

a gép-ember, a mesterséges és természetes intelligencia viszonylatában bekövetkezett

és amely az információ tartalmáról, annak virtuális, vagy valóságos voltára, így

az információ-biztonságra tereli a figyelmet.

Szellemi relaxációként bemutatok

néhány érdekes példát a zero-knowledge proof alkalmazására.

A sakk nagymester

probléma

Hogyan képes Valaki,

aki éppen csak a sakkjáték szabályait ismeri, méltó ellenfélként játszani, vagy

akár legyőzni egy sakk nagymestert ?

Valaki kihívja egyszerre Gary Kasparovot

és Anatolij Karpovot egy játszmára, ugyanabban az időpontban és ugyanazon helyen,

de két külön helyiségben (figyelemre méltó,

hogy a kísérleti elrendezés mennyire hasonlít a Turing-teszthez).

Valaki világossal

játszik Kasparov és sötéttel Karpov ellen.

1. Karpov,

mint a világos figurákkal játszó játékos megteszi a kezdőlépést. Valaki

megjegyzi a lépést és átmegy Kasparov helyiségébe, ahol Ő vezeti a világos figurákat,

így megteszi ugyanazt a lépést, amit Karpov tett.

2. Ekkor

megvárja Kasparov válaszlépését, amelyet szintén megjegyez és átmegy Karpov helyiségébe,

ahol Ő játszik a sötét figurákkal, így meglépi ugyanazt a lépést, amit Kasparov

lépett.

3. Ezt

az eljárást folytatja mindaddig, míg megnyeri valamelyik játszmát, vagy döntetlent

játszik mindkettővel.

Így Valaki

valóban szinte nulla ismerettel bizonyítja be a gyanútlan résztvevőknek (és nézőknek!),

hogy nagymesteri szinten tud sakkozni.

Az átlagéletkor

probléma

Hogyan lehet egy csoport tagjainak átlagéletkorát kiszámítani úgy, hogy

senkinek az életkora ne derüljön ki ?

Bár e kérdés felvetése úgy

tűnik főleg női társaságban aktuális, mégis a módszert számos igen komoly területen

is alkalmazhatjuk, ha például az életkor helyett jövedelem, vagyon, vagy akár szavazatok, vagy más titkos

adatok szerepelnek. Íme a problémához rendelhető zero-knowledge protocol:

1. Legyen

az A csoport tag adata a, a B csoport tagé b, a C csoport tagé c.

2. A választ egy tetszőleges (általában véletlen) számot, legyen ez

v és képezi az a'=a+v számot, amit egy borítékban átad B-nek.

3. B a borítékban kapott számhoz hozzáadja a saját adatát, azaz képezi

az b'=a'+b számot, amit egy borítékban átad C-nek.

4. C a borítékban kapott számhoz hozzáadja a saját adatát, azaz képezi

az c'=b'+c számot, amit egy borítékban továbbad.

5. Az

utolsó csoport tag a saját borítékját átadja A-nak,

aki a borítékban kapott számból kivonja a csak általa ismert

v értéket,

majd elosztja a csoport létszámával, így megkapják a csoport átlagértékét (pl.

átlagéletkor), anélkül, hogy bárkinek az adata mások számára kiderült volna.

Bírálható ez a protocol azzal,

hogy túl nehézkes az a megoldás, hogy minden csoport tag csak egymás után adhatja

le adatát, azaz az eljárás szekvenciális. Az eljárás könnyen "párhuzamosítható":

1. Legyen

az A csoport tag adata a, a B csoport tagé b, a C csoport tagé c.

2. A választ egy tetszőleges véletlen számot, legyen ez x és képezi az a+x számot.

a+x-et

az U urnába, míg x-et

a V urnába

dobja be.

3. B választ egy tetszőleges véletlen számot, legyen ez y és képezi az b+y számot.

b+y-t az U urnába, míg y-t a V

urnába dobja be.

4. C választ egy tetszőleges véletlen számot, legyen ez z és képezi a

c+z számot.

c+z-t

az U urnába, míg z-t

a V urnába

dobja be.

5. A

kiértékelés egyszerű, hiszen csak az U

urnában levő számok összegéből

(a+x+b+y+c+z) levonjuk a V

urnában levő számok összegét (x+y+z), ekkor pontosan a csoport

tagok adatainak összegét kapjuk (a+b+c), amelyet elosztunk a csoport létszámmal, így pontosan az adatok

átlagához jutunk. Világos, hogy mivel az U és V urnába

dobott számok utólag már nem összepárosíthatók, a számítások közben az egyedi adatok nem azonosíthatók, azaz

úgy számítottuk ki a csoport átlag adatát, hogy közben senkinek az egyéni adatára

nem derült fény.

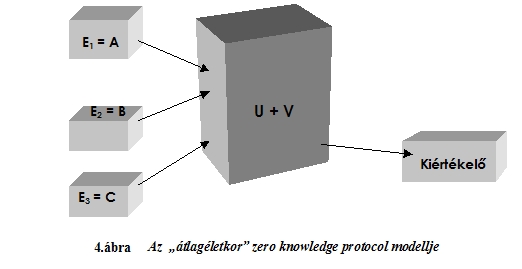

Vegyük észre, hogy ez a protocol

is könnyen megfeleltethető a 2.ábra

modelljének, hiszen az E1=A

, E2=B , E3=C

, U+V=”fekete doboz”, K=kiértékelő megfeleltetéssel éppen a 4.ábra modelljét kapjuk.

Érdekes annak a modell analógiának

végiggondolása, hogy ez a problémahelyzet nagyon hasonló bármely szavazáséhoz,

így például az országgyűlési választásokéhoz is. A jövő e-társadalmának egyik

perspektívája lehet az e-szavazás (elektronikus szavazás) lehetősége, amelynél

a zero knowledge protocol igen fontos szerephez jut. Ugyanakkor vegyük észre,

hogy mindhárom bemutatott példában a valódi üzenet elrejtése játszott alapvető

szerepet. Ha például a „sakk nagymester problémánál” nem biztosítjuk a két megfelelően

elkülönített helyiséget, akkor máris „meztelen a király”, vagyis meghiúsul az

utánzó játék lehetősége.

A globális e-kommunikációs

rendszerek azonban kitűnő lehetőséget biztosítanak a „virtuális szeparálódásra”

a minden információt „bekebelező fekete dobozban”. Ez a csapda helyzet már csak

látszólag hasonlít Turing modelljéhez, hiszen itt már nem a természetes és mesterséges

intelligencia szétválasztása az igazi probléma, itt már egészen új, talán minden

eddiginél nehezebben megválaszolható kérdés merül fel.

5. Az új kérdés:

Valós vagy virtuális információ ?

Szeretném, ha Ön is elgondolkodna azon, vajon eldönthető-e, hogy valós vagy

virtuális információ van a globális kommunikációs rendszer (2.ábra) fekete dobozában

?

Ez a kérdés nem azonos a

"természetes vagy mesterséges?"-sel, nem azonos az "igaz vagy hamis?"-sal,

ez a kérdés nem csupán a kommunikálókra és nem csupán a kommunikáció tartalmára,

hanem magára a kommunikációra vonatkozik.

Az emberi kommunikációnak

csak a verbális elemeit veszi át az e-kommunikáció, a fekete dobozba csupán a

"tartalom", vagy inkább annak is csak a "jel" része kerül.

Az emberi kommunikáció legalább 50%-át

alkotó metakommunikáció elvész. Pedig ez az, amitől az információ teljes, ez az

a redundancia, az a tartalék, ami a kommunikációs "hibák" felismerését,

esetleges javítását lehetővé teszi. Ez az 50% az, amely azt a vonatkoztatási alapot képezi,

amelytől a puszta "jel" valódi "jelentéssé" válik. Ez az a

csoda, amelyre Gábor Dénes (1900-1979) gyermeki naivitással rácsodálkozott, mikor

a holográfiát, a teljes kép rekonstruálhatóságát felfedezte. 1971. december 11-én

a Nobel-díj átvételekor tartott előadásán ezt így adta elő (lásd [GÁBOR 76] 15.old.):

"A közönséges fényképen azonban a fázisok teljesen elvesznek, a fénykép

csupán az intenzitásokat örökíti meg. Nem csoda, hogy elveszítjük a fázist, ha

nincs mivel összehasonlítani!"

Jelen szerző [DÉNT 78]-ban

általános rendszerekre is kiterjesztette az elméletet és bevezette az egységes

vonatkoztatási rendszer kategóriáját, mint olyan strukturális fogalmat, amely

alkalmas általános (így társadalmi), vagy éppen kommunikációs rendszerek modellezésére

és igen pontos leírására.

Megállapítható tehát, hogy

míg az közvetett (elektronikus) kommunikációnál minimális redundanciára törekszünk

(különböző gazdasági, racionális technikai megfontolások miatt), addig a közvetlen

emberi kommunikáció, a természetes rendszerek evolúciós törvényeinek megfelelően

"felfelé optimalizálja" a redundanciát, azaz az entrópiát maximalizálja.

Ez ad magyarázatot arra,

hogy az ember által racionális meggondolások szerint alkotott kódrendszereknél,

titkosításoknál is igyekszik ezt az elvet érvényesíteni, azaz a rejtjelzés

minimális redundanciával törekszik a maximális entrópiára. Lényegét tekintve

ebben az esetben a titkosítás ténye nyilvánvaló, bár a megfejtés lehet nagyon

nehéz (lásd [DÉNT 00/1]). A rejtjelzés csupán

a bemeneti információkhoz kötődő, statikus eljárás, így "érzéketlen"

a környezeti változásokra. Ez tehát a TALÁLD KI titkosítási filozófia.

Talán nem véletlen, hogy

a természet a titkosításra inkább a rejtést használja (pl. mimikri), amely éppen

a jelentős redundanciára épít. A rejtés optimumát ekkor nem a rejtőzködő, hanem

a környezete határozza meg! Ha megváltozik a környezet, akkor ezzel együtt kell

változni a rejtőzködőnek is (lásd [DÉNT 01/3]). Ez tehát a TALÁLD MEG titkosítási

filozófia (lásd például az előzőkben bemutatott „zero knowledge protocol”-t).

Turing tesztje és így a „természetes

vagy mesterséges intelligencia?” kérdésfelvetése a fentiek alapján a globális

e-rendszerekben már-már naivnak tűnő TALÁLD KI titkosítási filozófia feltételezésére

épült. A teszt ugyanis magában hordozza azt a rejtett feltételezést, hogy az emberi

nyelv tisztán információelméleti, illetve formális logikai megfontolások alapján

képes a „teljes információ” közvetítésére. Azonnal hiányérzetünk támad azonban,

ha az információ fogalma helyett az ismeret fogalmát használjuk

a közölt üzenettel kapcsolatban. Ekkor ugyanis az üzenet jelsorozat tulajdonságához,

annak jelentés tartalmát is hozzárendeljük, amely csupán valamely vonatkoztatási

rendszer (értelmező, vagy fogalom-rendszer) birtokában értelmezhető. (Emlékezzünk

Gábor Dénes holográfia elvére, amely a teljes kép, azaz a teljes információ rögzítésére

szolgál.)

Az információ mennyiségi

leírása statikus, melynek következtében a redundancia „felesleg”, így a mesterséges

rendszereknél a „racionális szervezés” igyekszik azt minimalizálni. Ugyanakkor

a természetes kommunikációnak a redundancia elengedhetetlen része (pl. metakommunikáció!),

hiszen éppen ez biztosítja azt a vonatkoztatási rendszert, amely az üzenetet jelentéssel

tölti meg.

Kalmár László több területen

korát jóval megelőzte (matematikai nyelvészet, algoritmus elmélet, kibernetikai

kutatások[10]),

így már az 1960-as években a kvalitatív

információelmélet problémájával foglalkozott. Igyekezett felhívni a figyelmet

az információelmélet továbbfejlesztésének szükségességére, s rámutatott, hogy

a jelek, jelsorozatok alakjában továbbított információ (üzenet) mennyiségi vizsgálatán

túllépve, az információ tartalmi-minőségi vonatkozásaival is törődni kell. Sajnos,

amint erre már az előzőkben utaltunk, a kor nem kedvezett eme gondolatok széleskörű

elterjedésének, de a XXI. századi információ alapú társadalom újra kikényszeríti

e problémakör megoldását.

Ennek jegyében tesszük fel

a következő kérdést: Lehet, hogy éppen a redundancia rejti a természetes és

mesterséges intelligencia között megbújó titok kulcsát ? Eme kérdésre adott

pozitív válaszunkkal mutatunk rá arra, hogy a titok kulcsa csupán egy olyan ajtót

nyit ki, amely mögött újabb titok lappang. Az újabb titok a „valós vagy virtuális

információ?” titka, amelynek megfejtéséhez már ez a kulcs kevés !

6.

Redundancia az információelméletben

Az információelmélet igyekszik minden információval

kapcsolatos fogalmat (jelenséget) számszerűsíteni, hogy azután a matematika eszközeivel

egzakt tételeket, összefüggéseket fogalmazhasson meg. Így egy üzenet információmennyiségét

(nem ismeret mennyiségét!), az üzenet váratlanságával jellemzi, amely tulajdonképpen

egy valószínűségi típusú érték. Jellemzésére a kinetikus gázelmélet modell-analógiából

származó „entrópia” fogalmat vezette be C.Shannon

(1916-2001), melynek lényege a következő[11]:

Adva van egy hírforrás, melyről

a szimbólumok (más szóval: egy ABC betűi)

előfordulási gyakoriságán kívül (ez végtelen hosszú, vagy végtelen sok üzenet

esetén megfelel a szimbólumok valószínűségének) nem tudunk semmit. Ha minden szimbólumot

két jelből álló jelsorozattal (0-1 bináris sorozat) akarunk leírni, akkor egy-egy

szimbólum leírásához átlagosan milyen hosszú bináris sorozatra van szükségünk?

Shannon erre az alábbi, általa

entrópiának nevezett (jelölése: H) matematikai összefüggést vezette

le (ahol pi az i-ik szimbólum előfordulási valószínűségét

jelöli):

H=-![]() bit/szimbólum

bit/szimbólum

(mivel ![]() mindig negatív érték,

így az összegzés pozitív H értéket ad)

mindig negatív érték,

így az összegzés pozitív H értéket ad)

Az entrópia modell-analógia

fontos tulajdonsága, hogy amint a fizikában zárt rendszerekre alkalmazzák az entrópia

tételt, úgy az információelméletben úgynevezett teljes eseményrendszerekre érvényes,

amelyekben teljesül, hogy ![]() =1

=1

Az entrópia és redundancia

könnyebb értelmezhetősége érdekében tekintsük a „fej vagy írás” játékot. Első

megközelítésben legyen teljesen szabályos a pénzérme, amellyel játszunk, így az

F fej és I írás dobásának valószínűsége egyforma, azaz

½. Ekkor a Hszab entrópia így alakul:

Hszab=![]()

Azaz 1 bittel leírható (0-1, igen-nem,

fej-írás, stb.) minden dobásnál a keletkező esemény (üzenet) és mivel az események

egyenlő valószínűségűek, így az információk váratlansága (bizonytalansága) a dobások

során nem változik. Tehát erre az 1 bitnyi információra feltétlenül szükség

is van, ha a dobás eredményét közölni akarjuk.

Most

vizsgáljuk a „cinkelt” pénzérme esetét, ahol például az F fej

dobásának valószínűsége ¾ , így az I írás valószínűsége

¼ . Ekkor a Hcink entrópia így alakul: ![]() Hcink=

Hcink=![]() =0.689

=0.689

Azaz alig több, mint kétharmad

bit elegendő lenne az így cinkelt pénzérmével való dobások eredményének közlésére,

hiszen az események váratlansága (bizonytalansága) ebben az esetben nem olyan

„meglepő” (a dobások többségénél ugyanis várható, hogy az F

fej lesz az eredmény).

Általában az információelméleti

entrópia akkor maximális, ha az alap ABC minden betűjének pi

előfordulási valószínűsége egyenlő (ez a valószinűség

n betűs ABC esetén, éppen ![]() ), ekkor vagyunk ugyanis a legbizonytalanabbak abban, hogy milyen

információ fog az üzenetben érkezni, míg ha az entrópia csökken, akkor bizonyos

információkat nagyobb valószínűséggel várhatunk, mint másokat. Az entrópia csak

akkor nulla, ha egy kivételével minden pi nulla, ami azt jelenti, hogy az üzeneteknek nincs „hír értéke”, hiszen

mindig ugyabból a szimbólumból (betűből) álló jelsorozat (üzenet) érkezik, amelynek

a valószínűsége így pontosan 1, azaz minden üzenet előre tudható, biztos

esemény.

), ekkor vagyunk ugyanis a legbizonytalanabbak abban, hogy milyen

információ fog az üzenetben érkezni, míg ha az entrópia csökken, akkor bizonyos

információkat nagyobb valószínűséggel várhatunk, mint másokat. Az entrópia csak

akkor nulla, ha egy kivételével minden pi nulla, ami azt jelenti, hogy az üzeneteknek nincs „hír értéke”, hiszen

mindig ugyabból a szimbólumból (betűből) álló jelsorozat (üzenet) érkezik, amelynek

a valószínűsége így pontosan 1, azaz minden üzenet előre tudható, biztos

esemény.

Az információelméleti redundancia

(jele: R) definíciója: R=![]()

azaz a relatív entrópiát 1-ből

levonjuk, ami megadja, hogy az üzenetben szereplő jelsorozat hányadrésze hagyható

el anélkül, hogy az az „érthetőséget” csökkentené.

Fel

kell hívni a figyelmet arra, hogy ebben az értelmezésben az „érthetőség”-et

információelméleti megközelítésben úgy kell érteni, hogy „az üzenetet képező

jelsorozat annak tartalmától függetlenül, szintaktikusan, azaz a nyelv formai

szabályainak megfelelően beazonosítható”.

Az

így értelmezett redundancia szerint (hosszú szövegeken végzett számítások alapján)

az emberi nyelvek redundanciája átlagosan 50%, ami azt jelenti, hogy ha valamely üzenet betűinek körülbelül

a felét elhagyjuk (természetesen véletlenszerűen kiválasztva a betűket), akkor

a fenti értelemben, érthetetlenné válik a szöveg. Az előzőkben bemutatott pénzérmés

példáinknál például a következő eredményre jutunk a redundancia kiszámításával.

A szabályos pénzérménél:

![]()

A

cinkelt pénzérménél: ![]()

Tehát

míg a szabályos érmével történő dobások esetén 0 redundancia mellett, minden

információra szükségünk van, hogy az üzenetet „megértsük”, azaz egyértelműen tudjuk

azonosítani (az üzenet itt a dobás eredménye), addig a cinkelt érme esetén, több

mint 30% redundancia mellett, a bejövő

információk majdnem egyharmada elhagyható.

Jó

példa a tudatos információ sürítésre a gyorsírás, ahol éppen a nyelvi redundancia

minimálisra csökkentése a technika lényege. Ugyanakkor lényeges momentuma ennek

az eljárásnak, hogy a gyorsírással rögzített szöveget, mihamarabb „gépbe írják”,

mivel egy idő után az egyedi jelölések asszociációs tartalma már nem rekonstruálható.

Példaként

álljon itt egy olyan mondat, amelyből először a betűk 21%-át, majd 39%-át hagytuk

el, mégis mindkét esetben a szöveget több-kevesebb gondolkodás után el tudjuk

olvasni: É-dekes -i-met -uta-tak

be az e-mu-t

-ap-kb-n. (21%-os tömörítés)

É-dek-s -i-m-t

-út—t-k be -z

e-mu-t -ap-kb-n. (39%-os

tömörítés)

Mindennapjaink

részévé váltak a képi információ sürítés szimbólumai, a piktogrammok, valamint

játékos formában a szöveg és képsürítés keverékei a képrejtvények.

A

redundancia csökkentésével tehát rövidíthetjük az üzenetek átlagos hosszát, de

kérdés, hogy mit tudunk kezdeni az így „optimalizált” üzenettel ? A válasz meglepő!

A

mesterséges kommunikációs rendszerek szempontjából valódi előny, hogy a rövidebb

üzenet gyorsabban átvihető és kisebb helyen tárolható. A kommunikáló felek szempontjából

azonban éppen fordított a helyzet, mivel így üzeneteink teljesen védtelenné válnak

mindenféle véletlen, illetve szándékos hibával, torzítással szemben.

Nulla

redundanciára érzékletes példa a LOTTÓ húzás, ahol nem lehet közelítőleg eltalálni

a főnyereményt, ellenben a beszédnyelvben megadhatunk egy szót közelítőleg, azaz

hibásan, akkor is felismerjük (pl.: ha „borotva”, helyett a „barotva” jelsorozat

érkezik). Fel kell hívni a figyelmet a beszédnyelv kihangsúlyozására, mivel ugyanez

például a számítástechnikában alkalmazott programozási nyelvekre nem igaz. Ott

az utasítások, formulák úgynevezett szintaxisát pontosan be kell tartani ahhoz,

hogy a gép „megértse”.

Fontos, hogy az előzőkben

vázolt információátviteli tulajdonságok, csupán a kommunikációnak a hírközlő csatornán

(ez lehet írott, hang, kép átvitelére alkalmas technikai eszköz) átvitt, üzenet

részére vonatkoznak.

Amint láttuk, az információelméleti

redundancia csökkentése lerövidíti az üzenetet, de véletlen, vagy éppen szándékos

hibák esetén megnehezíti, esetleg lehetetlenné teszi az üzenet megértését (azonosítását).

Ennek kiküszöbölésére a ![]() arány megnövelésével

(kódhosszúság megnövelésével), úgynevezett hibajelző (error detecting), illetve

hibajavító (error correcting) kódok képezhetők.

arány megnövelésével

(kódhosszúság megnövelésével), úgynevezett hibajelző (error detecting), illetve

hibajavító (error correcting) kódok képezhetők.

Neumann János már az 1950-es

években felvetette az önjavító, önreprodukáló gépek kérdését (lásd [NEUM 72]),

amelyre elméleti úton pozitív választ adott. Az információelméletnek ma már külön

ága a hibajelző és hibajavító kódok elmélete, amely matematikai leírást ad olyan

kódok létezésére és készítésére, amelyek megfelelő redundancia mellett, az üzenetben

keletkező, meghatározott mennyiségű hibás jel kiszűrésére, illetve kijavítására

alkalmasak. Enélkül a mai e-kommunikációs eszközök és hálózatok folyamatos, zavartalan

működése elképzelhetetlen lenne.

Anélkül, hogy részletesen

kifejtenénk az elméleti hátteret, szemléltetésként bemutatunk egy példát, 1 hibát jelző kódra:

Legyen egy egyszerű ABC,

amely mindössze négy betűből áll (B,T,I,O) és legyenek e betűk bináris kódjai

a következők:

B

= 100

T

= 010

I

= 001

O

= 111

5.

ábra

Ha üzenetünk például a BIT

szó, akkor az átviteli csatornán az 100001010

bináris jelsorozatot küldjük el. Azonban, ha az átvitel során véletlen, vagy szándékos

hiba keletkezik és a fogadó oldalon például a 000001010 jelsorozat érkezik meg, akkor a dekódolt

üzenet a következő lesz: 000 I T, amelyből rögtön kiderül, hogy az első karakter

hibás. Ugyanis az összes lehetséges három bitből álló kódok (számuk: 23=8)

a következők:

100 011

010 101

001 110

111 000

6.

ábra

így e táblázatból világos,

hogy az első oszlopban levő bármelyik kód egy bitjének megváltoztatásával, rögtön

átkerül a második oszlopba, azaz a két oszlopban leírt kódok éppen kiegészítik

egymást (komplementer viszonyban vannak!). Azonban két bit eltérést (pl.: 100

helyett 010) nem képes ez a kód jelezni,

hiszen ekkor csupán egy értelmes betű (B) helyett egy másik értelmes betűt (T)

kapunk (azaz az azonos oszlopba tartozó kódok kicserélődése történik).

Pontosan ezt a tulajdonságot

használják ki a rejtjelzésben alkalmazott „helyettesítéses” eljárások, melyeknek

az a lényege, hogy az úgynevezett „nyílt üzenet” alap ABC-jének betűihez egyértelműen

hozzárendelik az alap ABC, vagy egy másik ABC betűit. Az így keletkező üzenet

természetesen az illetéktelen olvasó számára értelmetlen jelsorozat (szöveg),

azaz titok (lásd [DÉNT 02/1]).

Ez a titok azonban ránézésre,

alig-alig különbözik a véletlen hibák által létrehozott „zaj”-tól, amely az információs

csatornák, mondhatni természetes velejárója. Az általunk TALÁLD KI rejtési filozófiának,

azaz a rejtjelzésnek pontosan az a célja, hogy a rejtjelzett üzenet minél inkább

hasonlítson egy nagy entrópiájú, azaz véletlen jelsorozathoz.

Ennél jóval bonyolultabb a helyzet, ha a betű eltérés, egy értelmes szó

helyett, egy ugyanolyan hosszúságú másik értelmes szót eredményez (pl.: BIT helyett

BOT), azaz amikor a TALÁLD MEG titkosítási

filozófiát követjük.

Témánk szempontjából igen

lényeges eme két probléma-típus felismerése, melynek lényege, hogy információelméleti

eszközökkel az „értelmes”, „érthető” fogalmak csak formálisan értelmezhetők, így

a mesterséges kommunikációs rendszerről fel kell tételeznünk, hogy bizonyos mennyiségű

„formális értelmetlenséget” produkál, ezáltal megkülönböztethető a természetes

intelligenciával rendelkező, „értelmes” rendszerektől. Pontosan erre épül a Turing-teszt, amely szerint a nagyon jól utánzó

gép, megkülönböztethetetlen a természetestől.

A Turing-teszt K kérdezője tehát azt

lesi, hogy mikor vesz észre „gépszerű” hibát („értelmetlenséget”) valamelyik válaszban.

A hiba fogalma azonban, mint az a fenti információelméleti gondolatmenetből kiderült,

legalább olyan nehéz fogalom, mint a természetes vagy mesterséges intelligencia

megkülönböztetése. Akkor vagy az eddigi eszközeink nem alkalmasak eme jelenségek

megkülönböztetésére, vagy maga a kommunikációs rendszer bonyolultabb, mint eddig

feltételeztük ?

7.

Redundancia a kommunikációban

"Amióta információelmélettel foglalkozom, sokszor eltűnődtem azon,

hogy fér el néhány verssorban összehasonlíthatatlanul

több információ, mint egy ugyanolyan hosszúságú, maximális tömörségű táviratban."

(Rényi Alfréd: Ars matematica)

Az információelmélet korlátai,

azaz, hogy a kommunikáció nem csupán az üzenet, mint információ átvitelét szolgálja,

hanem az üzenet által asszociált ismeret (jelentéstartalom) eljuttatását a fogadóhoz,

mint az a fenti idézetből kiderül, Kalmár László után a magyar matematika másik

jelentős gondolkodóját, Rényi Alfrédot is foglalkoztatta.

A XX.század középső évtizedeiben alkalmazott információátviteli

technikák mellett azonban eme gondolatokat háttérbe szorították, az akkor éppen

csecsemő korban levő információelmélet meghökkentő lehetőségei, amelyek a híradás

és számítástechnikában nyertek alkalmazást. Az információelmélet, majd a kódoláselmélet

eredményei adtak alapot az információ tárolás és átvitel egy egészen új korszakának,

a digitális technikának, amely lehetővé tette az „információs bumm” (információ

robbanás) kialakulását. A XX.század utolsó harmada az információ tömegtermelésének

kora, amely mint minden tömegjelenség, kezdte a „méregfogait” is kimutatni.

Az eltárolt temérdek információ

dzsungelében egyre nehezebb lett az eligazodás, így szükségessé vált az optimalizálás,

amely a kor szellemének és az elméleti, valamint technikai háttérnek megfelelően,

a mennyiségi paraméterekre vonatkozott. Hogy lehet az információt minél kisebb

helyre tömöríteni, ezáltal minél gyorsabban átjuttatni az információs csatornán

és végül minél kisebb helyen tárolni ?

A hardver eszközök térfogategységre

jutó kapacitása exponenciálisan nőtt, azaz egyre nagyobb mennyiségű információt

képesek tárolni, egyre kisebb helyen (lásd a ma már közforgalomban kapható laptop

(táska), palmtop (marok) számítógépeket), míg ugyanez a növekedés a „gépek” architektúrájában

és a felhasználó szempontjából létfontosságú gép és ember közötti kommunikációt

szolgáló szoftverben egyáltalán nem jött létre. A napjainkban tömegesen alkalmazott

asztali, laptop, palmtop számítógépek alapvető hardver architektúrája még mindig

megegyezik a Neumann János által leírtakkal, sőt amint az a jelen dolgozat történeti

bevezetőjéből kiderül, tulajdonképpen C.Babbage XIX. századi elképzeléseivel. Így a jelen globális kommunikációs

rendszereiben, a felhasználó ember teljesen magára maradt, szuper teljesítményű,

de „intelligenciáját” tekintve XIX. századi

digitális eszközeivel.

Az előzőkben bemutatott „fekete

doboz modell” tehát, Sándor György humoralista szavaival élve „egy szép,

nagy …, buta gyerek”, amelyre az jellemző, hogy mérhetetlen mennyiségű információt

képes tárolni és kritikátlanul visszaadni, de ismeretté formálni képtelen !

Napjainkra előállt tehát

az a paradox helyzet, hogy a redundancia egyszerre vált „ellenséggé” és mint a

fentiekben rávilágítottunk, az információ-biztonságot támogató eszközzé. A racionális

törekvések, a gazdasági, üzleti szempontok diktálta fogyasztói társadalomban mégis

az előbbi irányba húztak, sőt a digitális technika térhódításával egyre erőteljesebb

a redundancia „ellenség-képe”.

A digitális technikával,

ami napjaink és várhatóan a közeljövő uralkodó technikája, óriási számhalmazokká

képezzük le egész környezetünket, az e-kommunikációban még gondolatainkat is.

Így valójában egy digitális világot építünk fel, amely bizonyos értelemben újraéleszti

az ókori számmisztikát.

Püthagorasz és követői a

püthagoreusok (i.e. VI-V. század) alapvető világszemlélete volt, hogy „A dolgok

természete, lényege: a szám.”, de még a XIX. század végén Leopold

Kronecker (1823-1891) is így vélekedett:

„Az egész számokat az Isten alkotta, minden más az embertől származik.”

A

számmisztika legérdekesebb és talán legemberibb megnyilvánulása volt, mikor nem

a számokat személyesítették meg, hanem a személyes (emberi) tulajdonságokat „számosították

meg”, mint például a barátságos, vagy a tökéletes számok esetében, melyeknek titka

a mai napig rejtve maradt, még a legnagyobb matematikusok előtt is (lásd [DÉNT

02/1]). A számmisztika tehát a számok titokzatos, rejtett tulajdonságait tárta

fel, ílymódon igazolva azt a szemléletét, hogy az emberi változatosság a számok

tulajdonságaiban tetten érhető.

A digitális világ, azaz napjaink

számmisztikája ettől lényegesen különbözik, mivel a digitalizált információ

számdömpingjében éppen a számok „számtulajdonságait” hántjuk le és egyszerű „számkódok”-ként

használjuk fel őket. A digitális számhalmazok így tulajdonképpen jelhalmazokká,

kódhalmazokká válnak, amelyek semmiben sem különböznek a nem numerikus jelkészletektől

(szimbólumoktól, ABC-ktől).

Illusztrációként figyeljük

meg a „123 darab könyv” nyelvi üzenet esetét, amelynek ebben a formában

majdnem egyértelmű jelentést tulajdonítanak a magyar nyelven értők. Az emberi

intelligencia persze a nyelvi szokásjog alapján egyértelműnek tekinti azt is,

hogy a 123 szám tízes számrendszerben

értendő, így valóban „százhuszonhárom” darabnyi mennyiséget értünk az üzenetből.

A „123 db könyv” sűrített üzenet a magyar nyelv rövidítéseiben járatos

emberek számára még mindig egyértelmű (az előző kiegészítésekkel!). Mennyiségi

leírásnak tekintve ugyanez mondható el a „123 db” üzenetről is. A „123”

numerikus üzenet azonban már nem csupán nem hordozza önmagában e szám(ok) mennyiséget

leíró tartalmát, hanem numerikus volta is kétséges! Hiszen még ha mennyiségi tartalmat

feltételezünk, akkor is lehet bármely hármasnál

nagyobb alapú számrendszerben felírt szám, amelyek mind-mind lényegesen eltérő

mennyiségeket képviselnek. Például négyes számrendszerben a

„123”=”huszonhét valami”, ötös számrendszerben a „123”=”harmincnyolc valami”, tízes számrendszerben

a „123”=”százhuszonhárom valami”,

míg százas számrendszerben a „123”=”tízezerkétszázhárom

valami”. A „123” üzenet bizonytalansága

azonban ennél jóval nagyobb, mivel az 1, 2, 3 jelek tetszőleges

ABC betűit helyettesíthetik, azaz a „123” akár tekinthető ugyanolyan kódnak, mint az 5.ábra kódjai, csupán annyi bizonyos, hogy nem

bináris kód.

A globális e-kommunikáció

„fekete dobozában” tehát egyre nagyobb mennyiségű, mesterségesen elhelyezett,

„természetes értelmetlenség” található! A globális kommunikáció „fekete

doboza” pillanatnyilag úgy tekinthető, mint a digitális világ Bábel tornya,

amelyben az emberi nyelvek különböző számkódokká keveredtek össze, melyeknek megértéséhez,

azaz ahhoz, hogy az információk jel alakját ismeretté konvertáljuk, már egyáltalán

nem elegendő csupán a nyelv ismerete.

„A

beszéd a gondolatok eltitkolására való.” Talleyrand Périgord (1754 – 1838) herceg, francia diplomata

„A

nyelv nemcsak a közlés, hanem az eltitkolás eszközéül is szolgálhat.” Hermann Imre (1889 – 1984) Freud egyik legjelesebb követője

Ebben a „természetes rendetlenségben”

kell rendet teremtenünk, ha azt akarjuk, hogy „fekete dobozunk” hasonlítson a

természetes intelligenciához. Ennek módja azonban csak a TALÁLD MEG filozófián

át vezet. Azaz éppen a racionális, gazdasági, üzleti megfontolásokból feleslegesnek

tartott redundancia segítségével kell jelentést találni az információ (jel) tömegnek,

majd (ha még mindig nem értelmes számunkra az üzenet), a TALÁLD KI filozófia alkalmazásával

jutunk a számunkra is értelmezhető, azaz a természetes intelligencia számára befogadható

ismerethez.

Az ismeretet itt általános

fogalomként kezeljük, amely jelenti mindazt az asszociációt, amit az adott információ

az üzenet fogadójából kivált. Így világossá válik,

hogy míg az információ statikus, addig az ismeretre alapuló (jelentés tartalommal

bíró) kommunikáció dinamikus jelenség !

Kérdés tehát, hogy a TALÁLD

MEG filozófia kivitelezésére alkalmas-e az emberi (vagy egyéb) nyelv?

Ez a sarkalatos kérdés a „valódi vagy virtuális információ?” megválaszolásával

ekvivalens !

Világos ugyanakkor, hogy

ez nem azonos Turing kérdésével („természetes vagy mesterséges intelligencia?”),

így a Turing-teszt sem lehet alkalmas e kérdés megválaszolására.

Sőt az e-rendszerekben magának

a Turing-tesztnek az alkalmazhatóságát is bizonytalanná teszi!

8. Turing szemléltető példája

Turing idézett, úttörő jelentőségű

cikkében [TURING 50], demonstrációként bemutat egy elképzelt párbeszédet a

K kérdező és a V válaszadó között:

K: Kérem, írjon egy szonettet

a Forth-i Híd témájára (ez

egy híd a Firth of Forth folyón Skóciában)

V: Ne számítson rám, sohasem tudtam verseket írni.

K: Adja össze a 34957-et és a 70764-et.

V: 105621 (kb. 30 másodperc várakozás után jön a válasz)

K: Tud sakkozni?

V: Igen.

K: A királyom e1-en

áll és nincs más bábom. Az Ön királya e3-on áll, a bástyája az a8-on.

Ön következik. Mit lép?

V: Bástya a1

matt. (15 másodperc múlva jön a

válasz)

E párbeszéd jól mutatja,

hogy a K kérdező erőteljes törekvése ellenére, amely

az emberi intelligencia legjellemzőbb „műfajait” (művészi hajlam, rutin műveletek,

logikai képesség) igyekszik tesztelni,

a válaszokból nem könnyen vonhatunk le a „természetes vagy mesterséges?”

kérdés megválaszolásához messzemenő következtetéseket. Az azonban meghökkentő,

hogy az utánzási stratégia legtöbb problémája éppen a legegyszerűbb rutin kérdéssel,

az összeadással kapcsolatban vethető fel.

Azonnal feltűnik a hosszú

válaszolási idő (30 másodperc), ami gépi válasz esetén teljesen elfogadhatatlan,

emberi válasz esetén közepesnek tekinthető.

Azt azonban kevesen veszik észre, hogy a V válaszoló

által megadott eredmény helytelen (a pontos eredmény: 105721) és a tévedés is

„inkább emberi” tulajdonság. Hiba lenne ugyanakkor elhamarkodottan a

V válaszolót egyértelműen embernek minősíteni,

hiszen számtalan érv szólhat a „gépi tévedés” mellett is. Példaként néhány ilyen

hiba lehetőség:

-

véletlen hardver hiba

-

programozási hiba

-

rendszer hiba

El kell ismernünk, hogy ha

a V válaszoló meg akarja téveszteni a K kérdezőt (ha a

Turing-tesztet játéknak tekintjük, éppen ez a cél), akkor legalább olyan

nehéz feladata van, mint a K kérdezőnek,

akinek e válaszok alapján döntenie kell arról, hogy V gép,

vagy ember. A fenti rövid párbeszéd elemzéséből (amelyet idézett cikkében Turing

igen részletesen megtesz) kiderül, hogy Turing tesztje valóban „utánzó játék”,

azaz V számára kétféle stratégia követhető:

-

az ember utánozza a gépet

-

a gép utánozza az embert

Turing cikkében így foglalja

össze módszerének előnyeit:

„Az új problémafelvetés előnye

az, hogy elég éles határvonalat húz az ember fizikai és értelmi képességei között

…. Nem akarjuk ugyanis büntetni a gépet azért, mert nem képes szépségversenyen

tündökölni, de az embert sem, mert veszít egy repülőgép elleni versenyben.”

Márpedig az információs társadalomban

a Turing-teszt napi gyakorlattá válik és a globális kommunikációs rendszerek fekete

dobozában (mint arra az előző részben rávilágítottunk), a két stratégia bábeli

keveréke áll elő. Felmerül tehát ílymódon az információk azonosíthatóságának,

valódiságának, azaz az információ-biztonság garantálhatóságának problémája, vagyis

a „valós vagy virtuális információ?” alapvető jelentőségű kérdése, amelyre

mindenképpen egy információ-alapú társadalomnak válaszolnia kell !

9. A Turing-teszt e-gyakorlata

A

mesterséges intelligencia éppen az emberi racionalitás miatt, csak a jó, pozitív,

„hasznos” emberi, illetve élő tulajdonságokat igyekszik modellezni (lemásolni).

Hiszen az emberiségnek eme tulajdonságokkal lehet általában a teljesítményét maximalizálni.

Attól jó egy gép, ha „fáradhatatlan”, kiszámíthatóan, biztonságosan működik. Például

az emberi fáradást, betegségeket, vagy más tökéletlenséget senkinek nem áll érdekében

lemásolni, modellezni, gépi formában reprodukálni. Éppen ezért a mesterséges (gépi)

rendszerek tesztelésére olyan pozitív tulajdonságok, paraméterek meglétét tételezzük

fel, amelyekkel általában az ember (vagy az élő organizmus) rendelkezik. Ilyen

tulajdonságok például az organizmusban keletkező hibák kijavítása, az organizmus

reprodukáló, vagy alkalmazkodó képessége, stb.

A.Turing is arról beszél,

hogy az ezredfordulón, amit éppen jelenként élünk meg, „a gépek elég jól fogják

játszani az utánzó játékot” és ezalatt azt érti, hogy „elég intelligensen

lehet egy géppel kommunikálni”. Így tehát, ha Kempelen Farkas módjára egy gépben

elég ügyesen emberi intelligenciát helyezünk el (éppen ez történik az e-kommunikációs

rendszerek fekete dobozában!), azaz „virtuális gép-embert” készítünk, akkor a

saját teljesítményközpontúságunk akadályoz meg abban, hogy az utánzó játékkal,

mint tesztelési lehetőséggel célhoz érjünk, ha a gépet és az embert akarjuk megkülönböztetni

egymástól.

Turing fent idézett példája

tükrözi azt a humánus személyiséget, aki nem tud a valódi, a szó szoros értelmében

vett gép – ember viszonyon túllépni, akinek látnoki képzelőereje

sem volt képes a tiszta játékszabályokon túlra látni. Ezért csupa tényszerű, vagy

konkrét emberi cselekvésre irányuló kérdés (kérés) képezi a képzeletbeli párbeszédeit.

Kritikája, probléma listája is mélyen emberi! A valóságos jelenségvilágból nem

tud (valószínűleg nem is akar!) kiszakadni[12].

Ezért talán joggal hitte azt, hogy a tesztje valóban el tudja dönteni a „tudnak-e

a gépek gondolkodni?”, avagy a „természetes vagy mesterséges intelligencia?” kérdését.

Turing gondolatkísérlete,

mára a globális e-kommunikációs rendszerek mindennapi gyakorlata, amely az alábbihoz

hasonló párbeszédek millióit hozza létre a nap 24 órájában (az alábbi párbeszéd-töredék

csak modellezi a valódi gyakorlatot). A jelölések az 1.ábra Turing modelljének felelnek meg.

V: 8-kor a CSA-ban mindenki

ott lesz. Gyere Te is!

K: Mi a téma?

V: QKAC, IDTLEN és még sok más téma, ami mindenkit érdekel.

K: Szó lesz a PARA-MÉTER-ről?

V: Biztos, mert sok mindenről

szó lesz.

K: ….

Mint azt példánk is szemlélteti,

az általános alany stílusában (megszólítás, személyes azonosítás és azonosíthatóság

nélkül) megfogalmazott célirányos, „hatékonyságra” törekvő kommunikációnál, amely

az e-kommunikációban tulajdonképpen információtovábbítássá zsugorodik és szinte

„felesleggé válik” a metakommunikáció. Azaz a fentiek alapján éppen az üzenet

„jelentéstartalmának vonatkoztatási rendszere” válik az „idő pénz” szemlélet martalékává.

Igen szemléletesen mutatják ezt a tömörítési törekvést, az e-kommunikációban gyakorta

használt (csupán szűk kommunikációs csoportok számára érthető) rövidítések, vagy

például a tájékoztatásban, „reklám-kommunikációban” használt piktogramok, stb.

Az üzenetek jelentése, a tulajdonképpeni ismeret, az e-kommunikációban olyan titokká

válik, melynek „nyílt elrejtésére” a zero-knowledge protocolok bemutatásával mutattunk

példát.

A jelen információs társadalmában

az egyedek „észrevétlenül”, mint digitálisan tárolt adatsorok képződnek le a „fekete

doboz(ok)ba”, a „digitális Bábel tornyokba”. Ezek az adatsorok egyre több

és részletesebb adatot tartalmaznak, a tárolók részéről azzal a racionális igyekezettel,

hogy minimális legyen a tárolt információk redundanciája. Ugyanakkor alapvető

kérdés, hogy „ki a tároló (tárolt információk) tulajdonosa[13]

?”, aki(k)nek módjában lehet a „fekete dobozba” rejtett temérdek titok (információ)

ismeretté konvertálása, majd jó vagy rossz célokra való felhasználása. Ezt a problémát

már nyolcvan évvel ezelőtt, az információs társadalmat, a globális e-kommunikációs

rendszereket messze megelőzve (vagy talán látnoki módon megsejtve!), 1921-ben

felvetette Kosztolányi Dezső:

„Beírtak

engem mindenféle Könyvbe

és

minden módon számon tartanak.

Porzó-szagú,

sötét hivatalokban

énrólam

is szól egy agg-szürke lap.

Ó,

fogcsikorgatás. Ó, megalázás,

hogy

rab vagyok és nem vagyok szabad.

Nem

az enyém már a kezem, a lábam

és

a fejem, az is csak egy adat.

Jobb

volna élni messze sivatagban,

vagy

lenn rohadni, zsíros föld alatt,

mivel

beírtak mindenféle Könyvbe

és

minden módon számon tartanak.”

(Kosztolányi Dezső: A bús férfi panaszai-ból)

A Turing-teszt formális utánzó játékát tehát valóban

egyre „tökéletesebben” játszák és fogják játszani a gépek, azonban teljesen megváltozik

a viszonyítási alap (a „mihez képest?”), hiszen a K kérdezőt

és az E1 , E2 ,…

egyéneket egyaránt a C fekete doboz „kebelezi be” (lásd a 2.ábrát). Azaz mint a kifordított kesztyű, kerül

a külvilág (a valóság) a fekete dobozba, amelyen belül már valóban megkülönböztethetetlen

a kint és bent, a K

és E, így a C, K és E is!

Vagyis mindenki kérdező és válaszoló, mindenki természetes és mesterséges

intelligencia, mert nincs fogódzónk a valós és virtuális információ megkülönböztetéséhez.

A racionalitás, azaz az általános

redundancia-minimalizálásra törekvés során megszületik az e-társadalom, amelyben

e-rétegződés, e-mobilitás, e-kultúra és így egyáltalán e-gyetlen rendező elv szerepel:

ez az „e-gy értékű társadalom”.

Az

e-gy társadalomban az emberek e-mberekké válnak, azaz olyan digitális

információ- halmazokká, amelyek (és nem akik!) már a hatalom (az információs fegyver

birtokosai) számára nem különböznek bármely virtuálisan előálló információ-halmaztól,

így tetszés szerint manipulálhatók.

Szomorú,

hogy akárcsak Orwell 50

évvel ezelőtti „utópiája” (lásd G.A.Orwell: 1984 című regényét), mely szerint

„Az embernek annak tudatában kellett élnie, hogy lehallgattak minden hangot,

amit kiadott, s a sötétséget leszámítva minden mozdulatát megfigyelték.”,

amely a valóban elektronikus és globális ECHELON műholdas lehallgató rendszer

képében [DÉNT 01/2] mára megvalósult tény, ugyanígy sajnos az információs fegyver

elképzelése sem helyezhető az utópiák távoli világába, hiszen a mai reklám (főleg

az e-reklám, e-média, e-sajtó) és PR eszközök tartalmazzák már eme manipulációs

csírákat.

Lehet, hogy a globális információs rendszerekkel, az e-gy

társadalom alapkövét helyezzük el?

Lehet, hogy a XXI. század információs

társadalmának „csodafegyvere” a valós és virtuális világot megkülönböztethetetlenné

tevő információs fegyver lesz ?

Lehet,

hogy ez a fegyver az abszolút gazdasági racionalitás doktrínáját megvalósítandó,

már semmiféle látványos pusztítást nem végez, csupán a valódi emberek tömeges,

virtuális manipulációját valósítja meg, a globális és helyi hatalom kénye-kedve

szerint ?!

Lehet,

hogy ezekre és még sok hasonló kérdésre kellene egy valódi EMBER központú, valóban

TUDÁSALAPÚ társadalomnak igazi válaszokat keresni, mielőtt felállítja az „információs

társadalom = e-társadalom” egyenletet ?

A lehetőség ma még, az utolsó

pillanatban adott. Ehhez azonban fel kell ismernünk a már létező és a globális

e-gy társadalmakban rohamosan terjedő „virtuális agárverseny effektus”-t,

amely így fogalmazható meg röviden: „Érjük utol a nemlétező nyulat egy virtuális

agárversenyen !”

Zárszó helyett

Az 1999-es év egyik szenzációja volt, hogy a digitálisan

létrehozott „filmszínésznő”, Lara Croft világsikere után, egy kaliforniai filmcég

(Virtual Celebrity) bejelentette az első digitális klón megszületését. Ez a digitális

klónozás Marlene Dietrich arcát keltette életre és így a már régen elhunyt sztár,

egy újonnan készült 30 másodperces filmben szerepelhetett a maga „virtuális

valóságában”!

Digitálisan létrehozott „virtuális

barátaink” napról napra gyarapodnak, ezek sorából különös jelentőségénél fogva

ki kell emelni AnaNovát, az első virtuális televíziós bemondónőt, „aki” majdnem

tökéletes angol kiejtéssel, búgó hangján szól a képernyőkön keresztül rátapadó

(főleg férfi) nézőkhöz.

E „valós vagy virtuális információ?”

problematikáját elemző cikk végére, mint felkiáltó mondat végére, tette ki az

élő felkiáltójelet maga az élet:

„Az USA Legfelsőbb Bírósága engedélyezte a gyermek pornó filmeket, amennyiben nem élő, hanem csak virtuális szereplők szerepelnek benne.”

(MTI, 2002. április)

Irodalomjegyzék

[DÉNT 78] T.

Dénes: Graph theoretical approach to structural

representation of systems

Proceedings of the Fourth International

Conf. for Pattern

Recognition, Kyoto, Japan 1978.

[DÉNT 00/1] Dénes

Tamás: REJTJELFEJTÉS

Trükkök, módszerek, megoldások

Magyar Távközlés, XI.évf. 4.szám, 2000. április

[DÉNT 00/2] Dénes

Tamás: DIGITÁLIS UJJLENYOMAT

A dokumentumvédelem új korszaka

Magyar Távközlés, XI.évf. 5.szám, 2000. május

[DÉNT 01/1] Dénest

Tamás: Biztonságos Információ (s) Társadalom

INFO TÁRSADALOMTUDOMÁNY,

2001/53.

[DÉNT 01/2] Dénes

Tamás: ECHELON az e-társadalom információpajzsa ?

Híradástechnika, 2001/6

[DÉNT 01/3] Dénes

Tamás: SZTEGONOGRÁFIA

Rejtett információk rejtjelzés nélkül

Híradástechnika, 2001/8.

[DÉNT 02/1] Dénes

Tamás: TitokTan Trilógia 1.rész:

Kódtörő ABC

Kriptográfia Mindenkinek

Bagolyvár Kiadó, Budapest, 2002.

[DÉNT 02/2] Dénes

Tamás: INFOSANCE, a jövő

INFOrmációs renaisSANCE

társadalmának esélye

eVilág, I.évf. 4.szám, 2002.július

[DÉNT 02/3] Dénes

Tamás: A globális e-társadalom „kódolt”

kockázata

Társadalomkutatás, 2002. 20/3-4. 247-265

[FEFISH 87] U.Feige,A.Fiat,A.Shamir:

Zero-knowledge proofs of identity

in: Proceedings of the 19th ACM Symposium

on the Theory of Computing, New York,

ACM Press,1987.

[FUTÓ 99] Futó Iván (ed.):

Mesterséges intelligencia

Aula Kiadó, Budapest, 1999.

[GÁBOR 76] Gábor Dénes: Válogatott tanulmányok

Gondolat, Budapest, 1976.

[HODG 83] A. Hodges: Alan Turing: The Enigma.

Burner Books Ltd., London,

1983.

[KALM 86] Kalmár László: Integrállevél

Gondolat, Budapest, 1986.

[NEMES 62] Nemes

Tihamér: Kibernetikai gépek

Akadémiai Kiadó, Budapest, 1962.

[NEME 91] Nemetz Tibor, Vajda István: Bevezetés az algoritmikus

adatvédelembe.

Akadémiai Kiadó 1991.

[NEUM 72] Neumann János: A számológép és az agy

Gondolat Könyvkiadó, Budapest, 1972.

[NEWT 97] David E.Newton:

Encyclopedia of cryptology

ABC-CLIO, Santa Barbara, California, Denver,

Colorado,

Oxford, England 1997.

[PETSO 88] Ivars Peterson: Computing a Bit of Security: Zero-knowledge proofs in

Data Encryption

Science News, 16 January 1988.

[SHANN 48] C.E.Shannon:

The Mathematical Theory of Communication

Bell System Technical Journal, 1948. July and

October

[SHANN 49] C.E.Shannon: Communication Theory of Secrecy

Systems.

Bell System Technical Journal 28 (1949) 656-715.

[SHANN 51] C.E.Shannon:

Prediction and entropy of printed English

Bell System Technical Journal, 1951. January

[SHANN 62] Claude E.Shannon and Warren Weaver: The Mathematical

Theory of

Communication

Urban: University of Illionis Press, 1962.

[SINGH 00] Simon

Singh: The science of secrecy

(The secret history of codes and codebreaking)

London, 2000.

[STEW

96] Ian Stewart: Proof of Purchase on the Internet: Zero-knowledge

Protocols

Scientific American, February 1996., 124-125

[TARJ 58] Tarján Rezső: Gondolkodó gépek

Bibliotheca Kiadó, Budapest, 1958

[TURING 50] A.M. Turing: Computing Machinery

and Intelligence

Mind, 9(1950), 433-460

[WAYN 87]

Peter Wayner: Zero-knowledge proofs: Data Encryption

Byte, October 1987, 149-152